Dossier: L'IA, partenaire de recherche

Attendons l’inattendu

La combinaison de modèles linguistiques géants tels que GPT et de l’apprentissage par renforcement pourrait mener à ce que l’intelligence artificielle change fondamentalement la recherche elle-même. Coup d’oeil dans la boule de cristal.

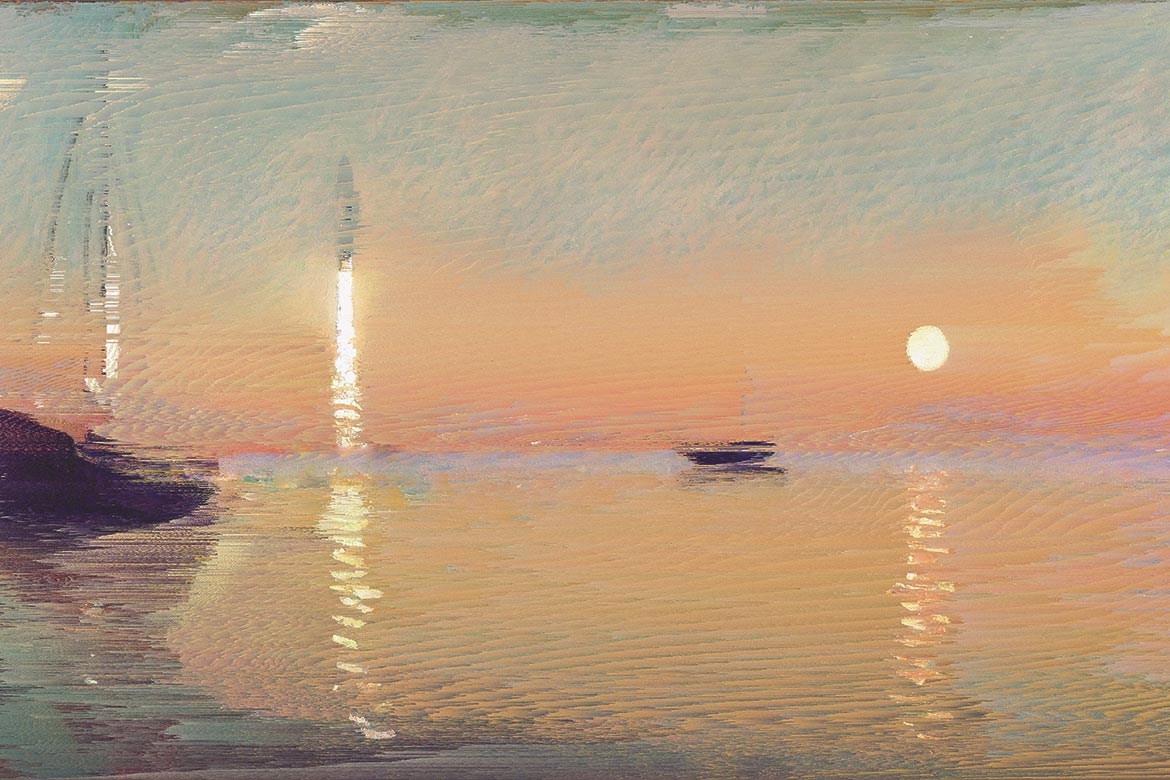

En binôme, l'artiste Jonas Wyssen et l'IA adaptent le célèbre tableau de Claude Monet «Impression, Soleil levant». A l'époque, l'impressionnisme a perturbé le monde de l'art et a ainsi posé de nouveaux jalons – exactement comme le font aujourd'hui les algorithmes. | Photo: Jonas Wyssen

Les modèles les plus récents d’intelligence artificielle entraînent des bouleversements d’une ampleur mythologique. Ainsi, le chroniqueur réputé du New York Times Thomas Friedman a comparé la situation actuelle provoquée par les générateurs de textes tels que GPT-4 et les générateurs d’images tels que Stable Diffusion avec celle amorcée par le dieu Prométhée qui, selon la légende, a donné le feu aux êtres humains, marquant le début de la civilisation. C’est, à ses yeux, le grand chambardement. «Nous ne pouvons pas nous contenter de petites adaptations, nous devons tout changer: notre manière de créer, de nous faire concurrence, de collaborer, d’apprendre, de gouverner et, oui, de tromper, de commettre des crimes et de faire la guerre.»

La recherche ne figure pas dans la liste de Thomas Friedman. Est-ce parce que l’exploration de territoires non encore cartographiés est réservée à l’être humain? Cette question occupe également le professeur de l’EPFL Rüdiger R. Urbanke qui, au Geneva Science and Diplomacy Anticipator, s’efforce d’évaluer le potentiel avenir de l’IA: «Si vous m’aviez demandé il y a trois mois quelles sont les professions les plus menacées par l’IA, j’aurais encore répondu exactement le contraire, à savoir que les emplois sont assurés partout où un certain degré d’originalité est important. Mais maintenant, avec GPT et Stable Diffusion, on peut subitement s’imaginer que l’ensemble de l’industrie créative doive faire face à une concurrence IA qui travaille tout à fait correctement.»

L’IA réussit à replier des protéines

Le professeur émérite de l’Université de Washington Pedro Domingos part de l’idée que l’IA fera un jour des recherches et de nouvelles découvertes de manière autonome: «OK, certains disent que l’apprentissage automatique peut certes identifier des régularités statistiques mais ne découvrira jamais quelque chose d’aussi profond que les lois de la gravitation de Newton», écrivait-il en 2016 dans son best-seller d’introduction à l’IA «The Master Algorithm». «Bien sûr, cela ne s’est pas encore produit, mais je parie que cela arrivera.» La question s’est posée dans le contexte du big data et a incité le spécialiste en technologie Chris Anderson à publier un manifeste pour une nouvelle science dans le magazine Wired: «Les corrélations supplantent la causalité et la science peut progresser même sans modèles cohérents, théories unifiées ou encore explications mécaniques. Il n’y a aucune raison de s’accrocher à nos vieilles pratiques. Il est temps de se demander ce que la science peut apprendre de Google.»

Les bouleversements actuels pouvaient à ce moment-là au mieux être pressentis. Mais entre-temps, l’IA s’est imposée comme un outil dans de nombreux domaines de la recherche académique sans soulever aussitôt des questions épistémologiques fondamentales. L’exemple le plus récent est AlphaFold, un programme qui, dans de nombreux cas, résout plutôt bien un vieux problème: prévoir précisément le repliement d’une protéine. Cette percée a été rendue possible par la société DeepMind qui a affiné ses méthodes au jeu de go. L’IA ne reçoit pas d’instructions précises pour trouver la solution, mais est optimisée en récompensant ses progrès et en sanctionnant ses reculs avec des points. Dans la méthode dite d’apprentissage par renforcement, l’IA décide elle-même comment obtenir une bonne réponse. Ce qui produit souvent des approches et des résultats inattendus – ce que les spécialistes du langage Go avaient à l’époque comparé à la découverte d’un nouveau continent.

On ignore encore si une IA créative permettra un jour aux scientifiques d’accéder à des zones inexplorées de la carte dont personne n’imagine encore l’existence. Spécialiste de l’évaluation de l’IA, Jack Clark, l’auteur de la newsletter influente «Import AI», voit en tout cas des parallèles entre le développement actuel de l’apprentissage par renforcement et celui, il y a quelques années, des grands modèles de langage tels que GPT. On peut constater un lien entre la taille et la prestation des modèles. Le développement s’accélérera encore dès que la performance des systèmes pourra être augmentée de manière décisive grâce à l’utilisation de ressources supplémentaires. La prochaine grande affaire pourrait donc être la combinaison entre l’apprentissage par renforcement et les modèles de langage: les scientifiques n’apprendront peut-être plus de nouvelles choses grâce aux méthodes d’IA, mais directement en dialoguant avec l’IA. Peut-être que l’ère de la recherche méthodique est loin d’être révolue, comme le pensait Chris Anderson, mais que les théories, modèles et explications mécanistes seront dès lors conçus par l’IA et non plus par les humains.

Plan décennal impossible

Cette vision peut sembler farfelue. Il est certes vrai que les grands modèles de langage ne calculent «que» la séquence de mots la plus plausible d’une saisie vocale. Mais depuis GPT-4 au moins, on ne peut plus se contenter de balayer les résultats d’un revers de la main et d’arguer que les modèles ne font que prétendre savoir quelque chose sans acquérir des connaissances applicables. A titre d’illustration, quand on invitait GPT-3, le modèle précédent, à une partie d’échecs, il jouait n’importe comment avec grande conviction. Mais avec le passage au modèle supérieur, un grand pas a été franchi: l’IA a aussi appris les règles du jeu et a atteint un niveau tout à fait respectable.

Rüdiger R. Urbanke conseille, de toute façon, de s’attendre à l’inattendu. Le vaste domaine de l’IA nous réserverait encore des surprises. «On ne peut pas faire un plan décennal, mais on doit rester proche des développements. Cela signifie qu’il faut faire de la recherche fondamentale.» Ce qui pose évidemment de nouveau la question des ressources pour des modèles devenant toujours plus puissants. Les infrastructures nationales pourront-elles même rivaliser avec les grandes entreprises? Pour Rüdiger R. Urbanke: «Ça ne doit pas être un CERN. L’union de quelques acteurs suffira.» Il n’est en tout cas pas inquiet à ce sujet: «En Suisse, nous sommes bien positionnés.»