Dossier: L'IA, partenaire de recherche

Une fois l’algorithme passé dessus, le tour est joué

L’IA est utilisée depuis longtemps dans la recherche. Six projets en cours, dans lesquels elle permet des avancées très particulières.

En finir avec les tumeurs malignes

Traiter des tumeurs cérébrales à croissance rapide demande des décisions tout aussi rapides. Pour cela, les médecins se fient aux images IRM. Mauricio Reyes de l’ARTORG Center de l’Université de Berne étudie depuis dix ans le glioblastome, une tumeur particulièrement agressive. Pour prédire sa croissance, il mise depuis l’an dernier sur un système d’IA capable de reconnaître différents éléments de la tumeur. Il doit pouvoir distinguer, à partir des clichés, les glioblastomes agressifs des moins actifs. Pour les premiers, le pronostic de survie est en moyenne de seize mois, pour les seconds, de plusieurs années. Les distinguer est donc central pour les thérapies. «Les systèmes d’IA permettent avant tout de gagner du temps», dit Mauricio Reyes.

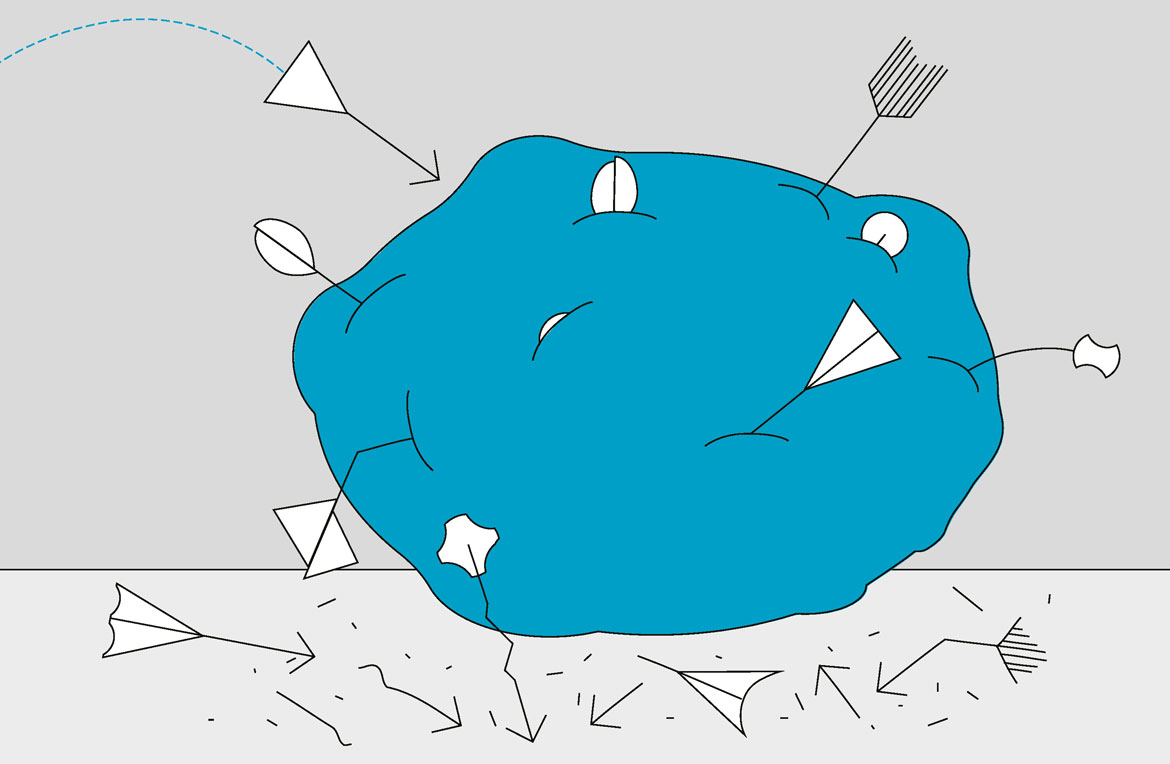

Pour entraîner l’IA, il a d’abord fallu lui apprendre à diviser la tumeur en zones: en régions mortes, en zones actives où les cellules malignes se multiplient rapidement et en zones périphériques dominées par les processus inflammatoires. L’évolution de ces zones devait permettre au système d’apprendre à reconnaître des variantes plus ou moins agressives. Avec succès: l’IA a pu prédire les variantes tumorales avec une précision de 88%. «Mais nous ne savions pas sur quelle base l’IA prenait ses décisions, note le chercheur. Ces systèmes sont souvent des boîtes noires pour nous.»

Mauricio Reyes a donc voulu comprendre quels pixels l’IA utilisait. «Nous avons découvert qu’elle examinait surtout les zones périphériques de la tumeur, pas les zones actives. C’était faux.» Les chercheurs appellent ce phénomène «shortcut learning». Dans ces cas, les systèmes d’IA livrent certes des réponses plutôt justes, mais pas aux bonnes questions. Or, surtout en médecine, se fier à un système en «boîte noire» peut avoir des conséquences fatales. Le chercheur a donc exclu de l’évaluation les zones périphériques de la tumeur, qui, comme les zones mortes, n’apportent guère d’informations. La précision des prévisions est alors montée à 98%. Le scientifique estime urgent de développer à l’avenir une intelligence artificielle capable de contrôler la qualité de l’IA. Son prochain projet s’intitule ainsi «KI für KI» (IA pour IA). Ce qui, jusqu’à présent, n’existait pas.

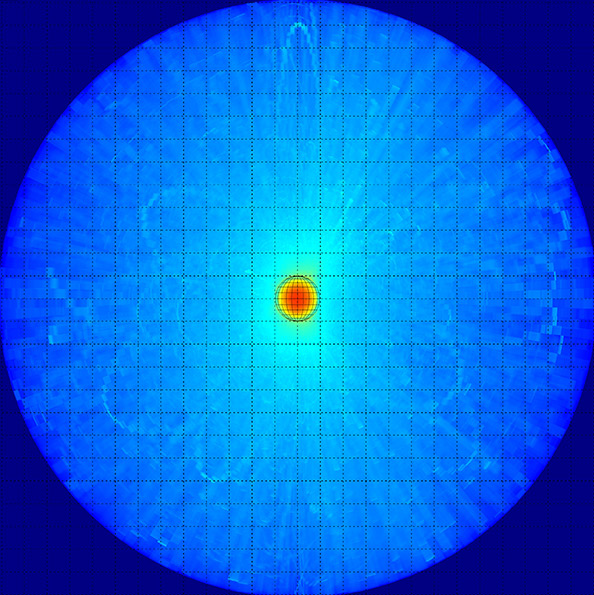

Dans l’ivresse d’une potentielle nouvelle physique

La découverte du boson de Higgs au grand collisionneur de hadrons (LHC) du CERN à Genève a entièrement démontré le modèle standard de la physique, permettant d’expliquer des forces partielles telles que l’interaction forte, l’interaction faible et l’interaction électromagnétique. Toutefois, la description de l’Univers reste incomplète, car ce modèle ne permet pas d’expliquer des phénomènes tels que l’énergie et la matière noires. D’autres particules existent donc probablement.

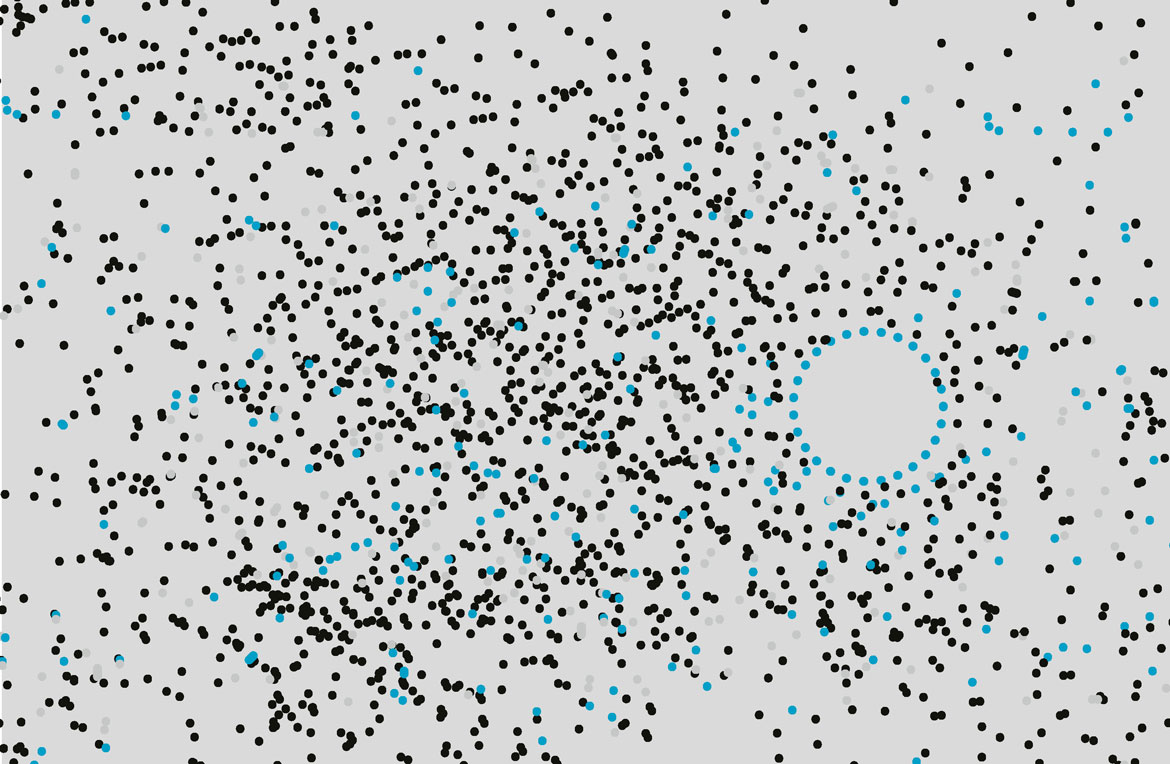

Des scientifiques de l’équipe de Steven Schramm de l’Université de Genève pensent pouvoir trouver des indices de particules non découvertes dans la profusion de collisions à basse énergie produites au LHC. A l’aide de l’IA, ils entendent transformer le «bruit» des données – issu par exemple d’imprécisions de mesure, de signaux superposés ou d’erreurs des appareils – en données et y reconnaître des modèles. L’un d’eux pourrait indiquer une particule qui expliquerait l’origine de la matière noire. «Nous espérons découvrir une nouvelle physique», dit Steven Schramm. Traiter les quantités gigantesques de données issues des détecteurs du LHC n’est possible qu’à l’aide de l’intelligence artificielle, note le chercheur. La tâche est ardue, puisqu’il s’agit de comprendre une image en 3D des signaux électriques issus d’une collision de particules.

Pour cela, les scientifiques utilisent ce qu’on appelle des réseaux de neurones graphiques. Le système est entraîné avec des simulations issues du modèle standard de la physique des particules. Il apprend ainsi à reconnaître des événements normaux. Ensuite, l’IA doit trouver des anomalies dans les données réelles du bruit de collisions, soit des indices d’une éventuelle nouvelle physique. En parallèle, l’IA doit exclure les anomalies attendues, c’est-à-dire les erreurs d’un détecteur du LHC.

«La quête d’anomalies avec l’aide de l’IA constitue une approche entièrement nouvelle pour chercher efficacement des phénomènes que la théorie n’a pas prévus», explique Steven Schramm. Et si la recherche échouait? On aurait au moins plus rapidement la certitude qu’aucune nouvelle physique ne se cache dans les domaines énergétiques étudiés.

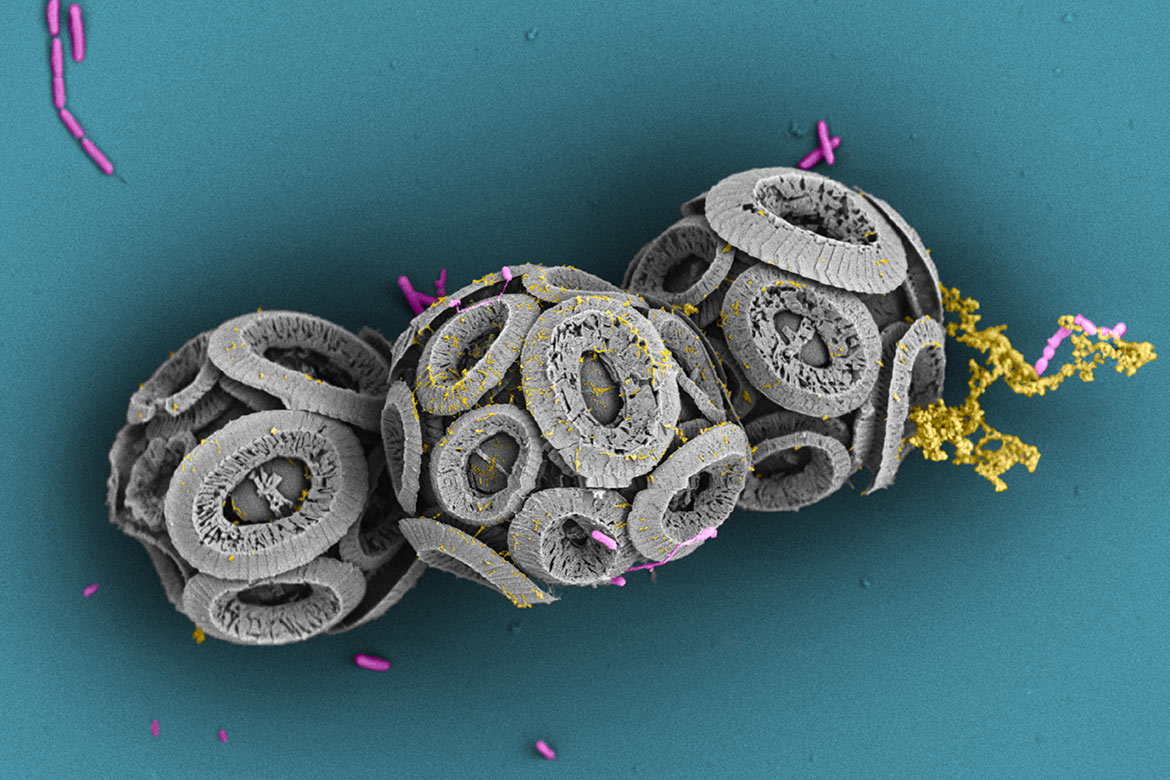

Pour que le médicament pénètre mieuxdans les cellules

Un des défis majeurs du développement de médicaments est d’amener les molécules thérapeutiques de manière précise à destination, en particulier lorsque les structures cibles se trouvent dans des cellules. Chaque cellule est entourée d’une membrane biologique protectrice qui règle aussi les échanges avec le monde extérieur. Il est donc essentiel de comprendre le comportement de ce qu’on appelle les peptides de pénétration cellulaire (CPP). Ces courtes séquences d’acides aminés peuvent traverser la membrane plasmique et introduire des molécules dans les cellules. «Il y a là un grand potentiel pour délivrer à l’avenir les médicaments de manière ciblée», dit Gianvito Grasso de l’Idsia.

Les méthodes classiques pour prédire le comportement de ces peptides demandent des modèles très gourmands en calculs ou des expériences exigeantes. L’équipe de l’Idsia a donc misé sur l’intelligence artificielle. Des algorithmes apprennent à analyser les grandes banques de données existantes comprenant les CPP connus et à en identifier de nouveaux ayant des propriétés analogues.

Le système a été entraîné avec des données issues de la littérature scientifique consacrée aux peptides de pénétration cellulaire et à d’autres peptides. Ces données contiennent des informations telles que leur séquence, leurs propriétés biophysiques et leur aptitude à traverser les membranes cellulaires. Le système d’apprentissage automatique de l’IDSIA a ensuite, à l’aide de ce même jeu de données, analysé les séquences d’acides aminés de peptides des deux types. Cela, afin d’identifier des structures liées à la facilité de pénétration des peptides dans les cellules.

L’objectif était de prédire précisément la capacité de différents peptides à traverser la membrane plasmique des cellules. Mais l’algorithme ne se contente pas de prédire le comportement des peptides. Il propose aussi des modifications de séquences afin qu’un peptide pénètre plus facilement dans une cellule, explique Gianvito Grasso. L’outil doit faciliter l’évaluation des peptides avant leur synthèse.

Manuscrits très anciens sous la loupe numérique

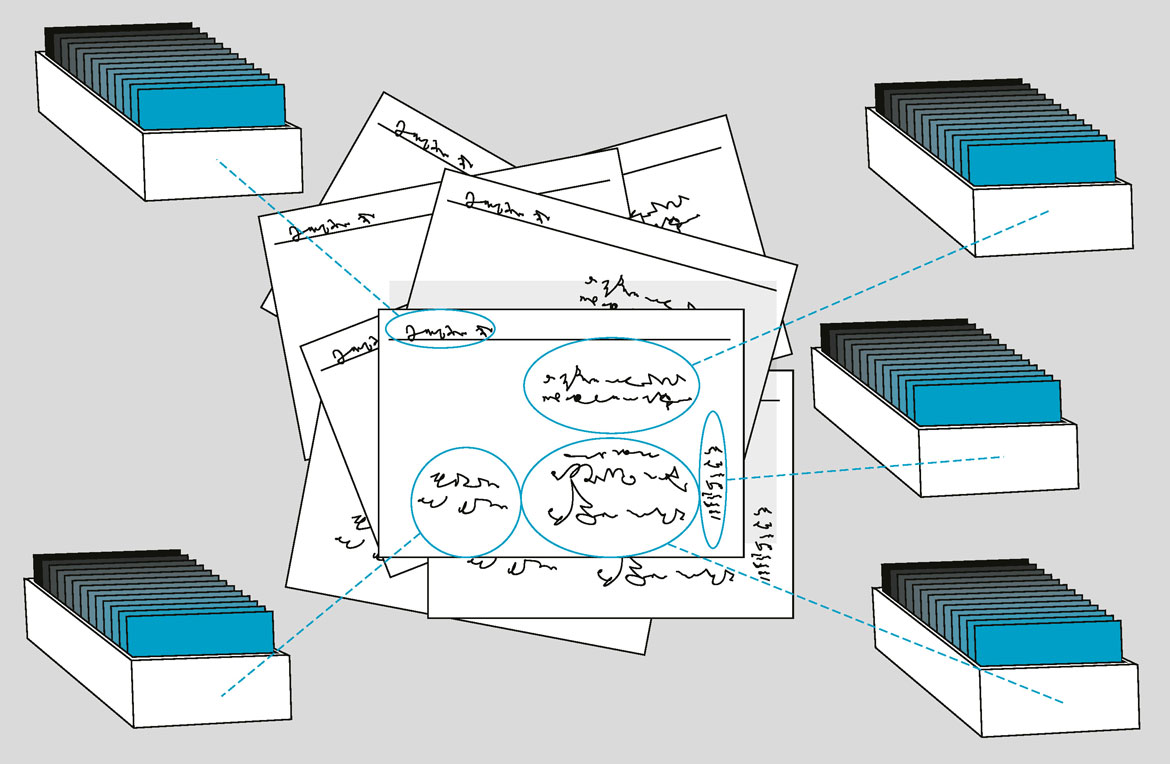

Le registre foncier historique de la ville de Bâle comprend plus de 220 000 fiches d’information sur le bâti de la ville qui remontent jusqu’au XIIe siècle. «Pour les historiennes, un fichier comme celui-ci a une énorme valeur», dit Lucas Burkart de l’Université de Bâle. Mais les notices sont manuscrites. Afin d’en faciliter l’accès aux scientifiques, Lucas Burkart et son collègue Tobias Hodel de l’Université de Berne misent désormais sur des méthodes de décryptage basées sur l’IA.

L’objectif est de saisir le contenu des fiches et de l’évaluer sur une période de 300 ans (1400-1700). Les scientifiques entendent ainsi comprendre toutes les notions, prescriptions et procédures usuelles liées à la propriété foncière en ville de Bâle et analyser ensuite les changements dans l’immobilier. Cela, autant dans des cas particuliers tels que celui du couvent de Klingental que pour l’ensemble de l’espace urbain.

Dans ce but, les scientifiques utilisent différentes procédures d’apprentissage automatique, en particulier le traitement automatique de la langue naturelle (NLP). D’abord, le système localise les zones de texte sur la fiche. La deuxième étape consiste à saisir correctement les éléments manuscrits, soit de lire les mots eux-mêmes dans la langue et l’écriture employées (latin et anciennes formes d’allemand). La troisième étape est la plus complexe: «Ici, nous décomposons chaque fiche en ce que nous nommons des ‘events’», dit Tobias Hodel, soit des actions telles qu’achat, vente ou saisie dans lesquelles des personnes ou des institutions telles que les monastères sont impliquées.

«Ces événements ne sont pas toujours évidents et peuvent parfois s’inscrire dans un contexte historique particulier qui n’est pas immédiatement compréhensible», note Lucas Burkart. «Un concept tel que ‘les intérêts’ recouvre ainsi différentes formes de transactions économiques.» Le projet a aussi un objectif plus général. «Nous essayons de mesurer le taux d’erreurs à différentes étapes de l’analyse automatique, par exemple lors de la saisie des éléments manuscrits», explique Tobias Hodel. La question est ici celle de la fiabilité des résultats obtenus grâce aux méthodes recourant à l’IA. Ces analyses du système doivent devenir «partie intégrante du développement méthodologique de l’histoire en tant que science».

Déceler le changement climatique par les arbres

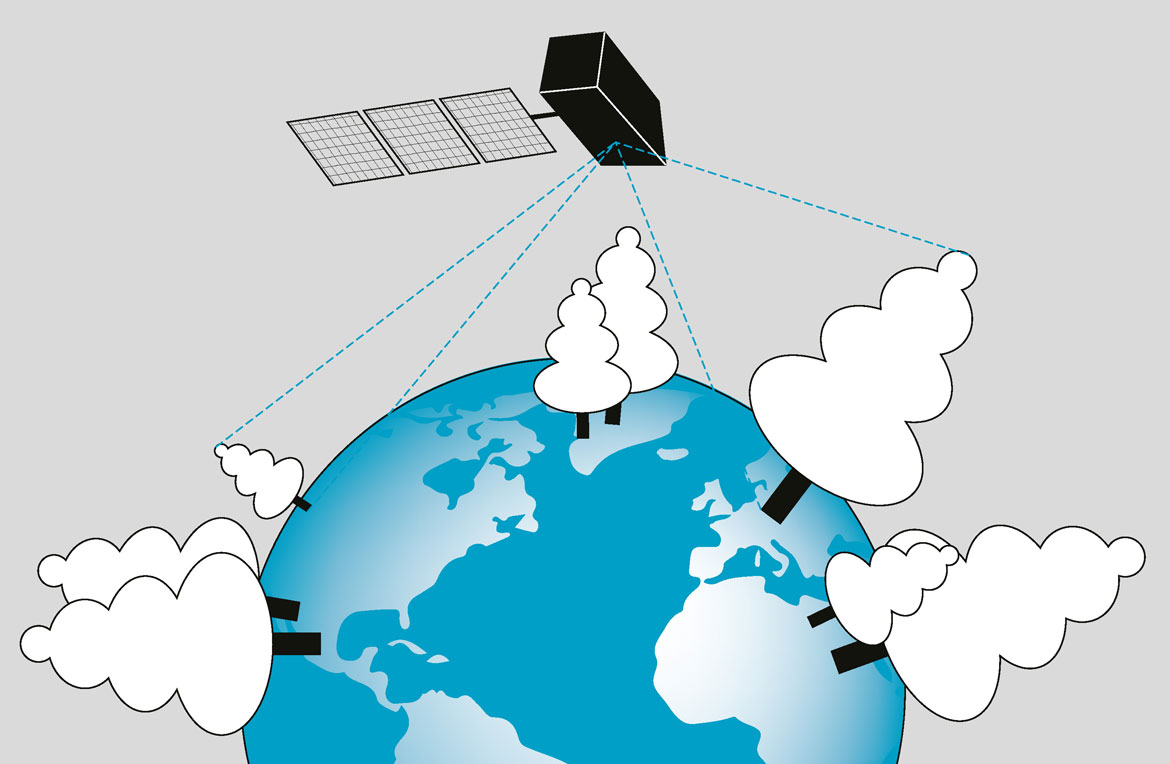

De prime abord, mesurer la hauteur d’un arbre ne nécessite pas d’intelligence artificielle. Or, Konrad Schindler veut mesurer celle de tous les arbres de la Terre. Des données extrêmement importantes car, à l’aide de modèles, elles permettent de déterminer la répartition de la biomasse sur la Terre et donc le dioxyde de carbone contenu dans la végétation.

«Nous sommes les cartographes des hauteurs de la végétation», dit le géodésien et informaticien. Ce qui l’intéresse: savoir comment, à l’aide de l’IA, on peut cartographier automatiquement des grandeurs et des relations importantes pour l’environnement, telle la densité de végétation, ce qui n’était pas vraiment possible jusqu’à présent. «Notre technologie permet même de mesurer correctement les grands arbres, particulièrement importants en termes de biodiversité et de biomasse», note le chercheur.

La méthode est complexe, car les données auxquelles le chercheur fait appel pour entraîner son système sont des images en pixels prises par les caméras des deux satellites Sentinel 2A et 2B de l’ESA. Et les données de référence pour l’entraînement sont les mesures de hauteurs d’arbres réalisées par le scanner à lasers GEDI que la NASA a monté sur la station spatiale ISS. Des centaines de millions de mesures individuelles ont déjà été effectuées depuis là-haut.

Comme le lien entre les informations contenues dans les pixels et la hauteur des arbres est trop complexe pour établir un modèle physique, Konrad Schindler recourt à l’apprentissage automatique. Le système se base sur un réseau neuronal profond également capable de donner l’incertitude statistique des résultats – soit le risque d’imprécision. Les scientifiques parlent ici de «probabilistic deep learning».

Dans le futur, cette carte pourrait livrer des indications capitales pour prendre des mesures adéquates contre le changement climatique et l’extinction des espèces. Elle pourrait servir au monitoring de certaines régions forestières ou de territoires protégés. En Suisse, des discussions sont déjà en cours avec l’Institut fédéral de recherches sur la forêt, la neige et le paysage WSL.

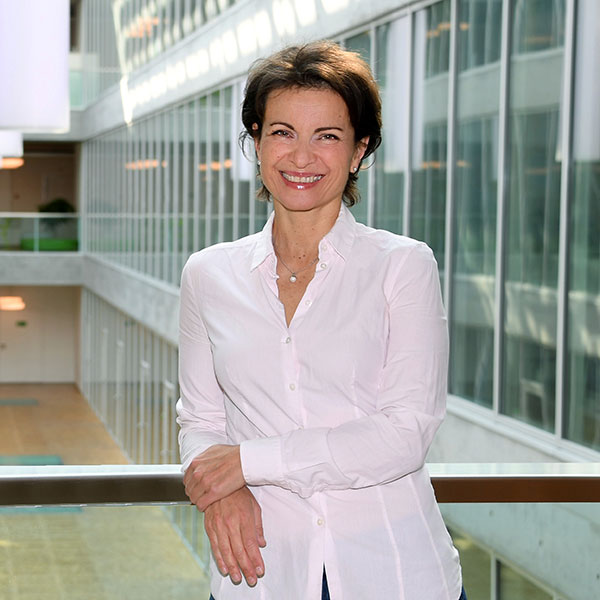

De l’ordre dans le chaos des données de santé

Les personnes âgées souffrent fréquemment d’effets secondaires de médicaments et sont plus sensibles à leurs interactions indésirables. Une équipe de l’Idsia de Lugano développe donc une IA pour l’analyse automatique de leurs dossiers médicaux dans les hôpitaux afin d’identifier assez tôt des complications possibles.

Les données traitées sont complexes pour une IA, car les dossiers médicaux contiennent souvent beaucoup de textes. Sans compter qu’en Suisse les médecins y notent leurs observations et diagnostics dans les différentes langues nationales. De plus, les données y sont très peu structurées. C’est pourquoi, afin d’en extraire des informations utiles, l’équipe de l’IDSIA réunie autour de Fabio Rinaldi a eu recours tant au traitement automatique de la langue naturelle – qu’utilisent également des systèmes très débattus aujourd’hui tels que ChatGPT – qu’à la fouille de textes. L’objectif était que l’IA identifie les événements indésirables et leurs causes.

Concrètement, le projet portait sur les effets secondaires des médicaments antithrombotiques. Pour contrôler la qualité, l’IA utilisait les expériences provenant de quatre hôpitaux suisses participant à l’étude sur les interactions de différents médicaments.

Une question importante dans la gestion des données des patients et des patientes utilisées pour l’entraînement est celle de l’anonymat. L’équipe de l’IDSIA a d’abord dû anonymiser l’ensemble des dossiers médicaux avec des instruments NLP adéquats. L’anonymisation des rapports cliniques recèle un grand potentiel, comme l’explique Fabio Rinaldi, et cela, bien au-delà de son propre projet. «Nous voulons rendre de précieuses informations médicales utilisables à des fins de recherche.» De manière générale, réunir à grande échelle des données concernant la santé permet d’acquérir des connaissances médicales auxquelles il ne serait pas possible de parvenir en étudiant de manière isolée quelques cas seulement.