Dossier: Nouveaux regards sur l’école

Pourquoi l’enseignement ne se fait pas encore sur des bases scientifiques

De nombreuses recherches ont déjà identifié les mesures qui améliorent l’apprentissage, mais ces conclusions n’atteignent que trop rarement les salles de classe. Petit tour d’horizon de ce que la science sait de l’enseignement – et de ce que les écoles en font.

Des méta-analyses ont identifié ce qui permet aux élèves de prendre leur envol. | Image: Nicolas Zonvi

L’école se trouve au coeur de nombreuses discussions et de bien des disputes. Enseignants, parents ou politiciens: tous ont une opinion sur ce qu’elle devrait être et devrait fournir à la société. Des convictions souvent pratiquement impossibles à ébranler, alors que chacun a le même objectif en tête: offrir le meilleur enseignement possible.

La recherche en éducation a livré de très nombreuses connaissances sur la manière dont il faudrait organiser l’enseignement scolaire pour assurer le meilleur apprentissage. Mais «ces connaissances arrivent encore trop rarement jusqu’aux salles de classe», relève Wolfgang Beywl, chercheur à la Haute école pédagogique de la FHNW à Windisch (AG). Il observe un fossé entre la recherche et la pratique de l’enseignement qui reste difficilement franchissable d’un côté comme de l’autre. Pour lui, les débats dans le monde politique ne sont pas en phase avec les résultats de recherche.

L’étude monstre de Hattie

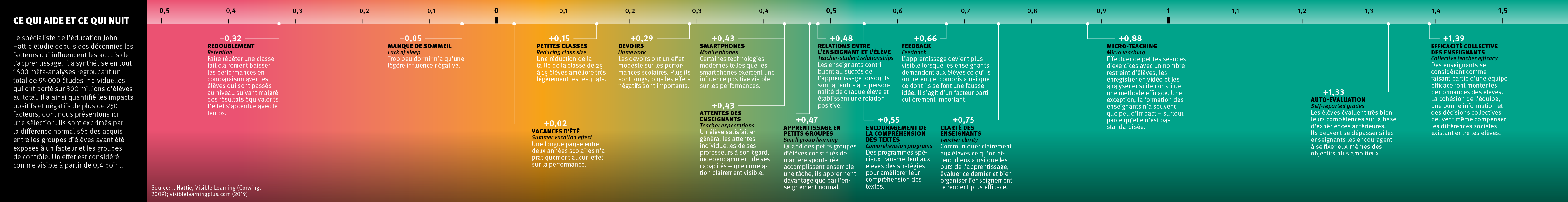

Mais reprenons dans l’ordre. Pendant plus de vingt ans, le chercheur John Hattie a travaillé pour identifier les facteurs qui influencent la réussite de l’apprentissage chez les enfants et comprendre comment ils y parviennent. Ce Néo-Zélandais, qui enseigne aujourd’hui à l’Université de Melbourne, a évalué dans le cadre d’une étude monstre toutes les publications en anglais résumant les recherches sur la réussite scolaire: une méta-méta-analyse de 800 méta-analyses portant sur plus de 50 000 études conduites sur 250 millions d’élèves. En 2009, il a présenté ses résultats dans l’ouvrage «Visible Learning». «Cela a été un déclencheur», commente Wolfgang Beywl, qui a contribué à sa traduction en allemand et dont la recherche s’appuie sur les conclusions de John Hattie. Pour la première fois, la discussion sur la réussite scolaire des enfants et les facteurs qui y contribuent a été portée bien au-delà des écoles.

Depuis, la star néo-zélandaise de l’éducation a régulièrement complété ses résultats avec des analyses d’études plus récentes. Entre-temps, plus de 1600 méta-analyses de 95 000 études ont été intégrées à son enquête. John Hattie y a identifié plus de 250 facteurs qui influencent l’apprentissage des élèves, en le stimulant ou en le freinant, et chiffré leur impact. Par exemple, les techniques d’apprentissage, la culture du feedback, les devoirs à domicile ou encore la clarté de l’enseignant.

Explorez l'infographie à l'aide de la souris.

L’analyse de John Hattie a livré des résultats inattendus, comme dans le cas des devoirs: ces derniers n’aident en rien les enfants à apprendre, tout au moins pendant les premières années d’école. Ce n’est qu’au degré secondaire post-obligatoire (en Suisse dès 15 ans) qu’ils peuvent éventuellement s’avérer utiles. «Mais là encore, tout dépend de la manière dont ils sont conçus et si les élèves reçoivent un feedback utile», souligne Wolfgang Beywl. Un impact étonnamment faible est également apparent pour d’autres facteurs liés aux structures scolaires et aux ressources, telle la taille de la classe ou encore à quel point la répartition des enfants en différentes filières se fait de manière stricte.

Les profs sont décisifs

A l’inverse, John Hattie a mis en évidence qu’une centaine de facteurs déterminants pour le succès étaient liés à ce qu’on appelle les pratiques d’enseignement, c’est-à-dire les méthodes et les actions déployées par l’enseignant pendant les cours. «Cela a clairement démontré et de manière empirique que le comportement de l’enseignant en classe est décisif», commente Wolfgang Beywl. Et que la différence que peuvent faire les enseignants est considérable: environ un tiers de la réussite de l’apprentissage chez les enfants dépend de leur comportement.

Evidemment, ces travaux ont également été critiqués. «Il a commis quelques erreurs de calcul», note Wolfgang Beywl, un fait peu étonnant au vu de l’immense volume de données étudiées, à l’instar des valeurs moyennes simplifiées. John Hattie a par la suite corrigé ces erreurs avec Wolfgang Beywl.

Les conclusions de cette étude et de bien d’autres travaux n’ont quasiment pas atteint la pratique, à savoir les enseignants dans les salles de classe. Une raison est que les résultats de recherches en éducation n’ont pas la même universalité que ceux des sciences naturelles. «L’expérience montre qu’ils ne peuvent souvent presque pas être généralisés, car ils sont très marqués par un contexte donné», explique Stefan Wolter, directeur du Centre suisse de coordination pour la recherche en éducation à Aarau. Les résultats issus d’un pays ne sont guère transposables dans d’autres, et une mesure concrète qui, selon une étude, fonctionne bien dans certains établissements peut s’avérer complètement inefficace ailleurs.

D’autres problèmes viennent s’y ajouter. «Les chercheurs en éducation ont rarement la possibilité de suivre des protocoles d’études vraiment solides», explique Stefan Wolter. Notamment inclure un nombre significatif de classes réparties au hasard entre groupes d’intervention et de contrôle, la mesure étant testée dans le premier groupe et l’enseignement normal continuant d’être dispensé dans le second. Mais dans la réalité, le fait que des écoles participent aux études sur une base volontaire au lieu d’être sélectionnées de manière aléatoire induit déjà des biais systématiques.

La Suisse a tout de même connu des études conduites avec des groupes de contrôle comparables, dont les élèves avaient des caractéristiques telles que l’âge, le sexe ou encore l’origine sociale similaires à celles des classes d’intervention. Urs Moser, chercheur en éducation à l’Université de Zurich, en a mené quelques-unes auprès de toutes les écoles d’un même canton.

Mais les études qui n’ont pu procéder à une sélection faite au hasard produisent des résultats susceptibles d’être entachés de variables perturbatrices. Car les influences dans l’apprentissage sont très nombreuses – rien que le quartier où grandit un enfant a un impact. «Il est impossible de contrôler (compenser, ndlr) complètement de tels facteurs extrascolaires ou de les mettre parfaitement en évidence dans les données», souligne Urs Moser. Dans ces conditions, il est difficile d’émettre des conclusions de portée vraiment générale.

Analyser sa propre pratique

Un élément essentiel ressort des travaux d’Hattie: chaque enseignant tient entre ses mains de nombreux facteurs importants pour la qualité de ses cours. Mais en tirer profit exigerait de se fier moins à son intuition et de vérifier davantage l’impact de ses leçons, en générant ses propres données. C’est là le gage d’une amélioration systématique.

Wolfgang Beywl et son groupe de recherche s’efforcent de familiariser le corps enseignant avec cette idée et ont développé à son intention un ensemble d’outils («Lehren und Lernen sichtbar machen», une référence aux travaux de John Hattie). Par exemple, une marche à suivre explique comment instaurer la bonne culture du feedback: les retours (reçus et donnés par les élèves) doivent être fréquents et constructifs, l’un des facteurs clés identifiés par John Hattie. Il ne s’agit pas là d’un questionnaire remis en fin d’année aux élèves pour qu’ils y notent leurs enseignants, un simple feedback rétrospectif, souligne Kathrin Pirani, chercheuse dans le groupe de Wolfgang Beywl et enseignante d’anglais, mais d’évaluer l’environnement d’apprentissage sur le moment et d’obtenir des améliorations.

Luuise est un autre instrument pour aider les enseignants à améliorer leurs cours. Il les invite à analyser des problèmes concrets issus de leur propre enseignement, à tester des mesures pour les résoudre et à en évaluer l’efficacité en recueillant des données. (Son adaptation en français porte le nom de EEVE.) Cela permet de faire évoluer l’enseignement sur la base de preuves, explique Kathrin Pirani, qui dirige chaque année cinq ou six formations continues basées sur cet outil. «Les enseignantes et les enseignants peuvent suivre l’évolution de leurs leçons et les adapter de manière ciblée en fonction de ce dont les élèves ont besoin pour faire des progrès.»

Mais transmettre ce type d’outils reste difficile, et seule une minorité d’enseignants est atteinte pour l’instant. Si environ 800 d’entre eux ont appris à utiliser la méthode Luuise dans le cadre d’une formation continue et l’ont diffusée en partie dans leurs classes, la Suisse dénombre plus de 40 000 enseignants dans les écoles primaires. Les chercheurs veulent en former davantage. «Nous publions des articles dans des revues professionnelles et menons des projets pilotes dans des établissements scolaires pour tester les instruments et les diffuser», détaille Wolfgang Beywl. L’idée est aussi d’intégrer davantage Luuise dans la formation initiale. C’est déjà le cas à la Haute école pédagogique de Berne, dans les cours de didactique de l’anglais et du français. D’autres disciplines devraient suivre.

Dans sa recherche laborieuse d’écoles voulant participer à ces projets, Wolfgang Beywl constate un fossé entre recherche et pratique: «Je vois grandir une réticence vis-à-vis de la collecte de données», qu’il dit compréhensible au vu de l’essor du monitoring au cours des vingt dernières années et dont les écoles n’ont pas retiré de bénéfice. Car les grandes enquêtes comme l’étude PISA ou la vérification de l’atteinte des compétences fondamentales (COFO) dans toute la Suisse travaillant avec des données sont anonymisées et des classements faits par les pays. Les écoles, elles, ne savent donc pas quels résultats elles ont obtenus «et ne retirent aucun gain de connaissances de leur contribution», selon Wolfgang Beywl.

L’analyse est partagée par Beat Schwendimann du LCH, l’association faîtière des enseignants de Suisse alémanique: «Dans le cas de Pisa, mais aussi dans nombre de projets de recherche des hautes écoles pédagogiques et des universités, les écoles ne reçoivent aucun retour qui puisse leur être utile.» Il dit souhaiter que la communication des résultats dès le début devienne une évidence pour les projets de recherche. L’important pour les chercheurs en éducation ne serait pas uniquement de publier les résultats dans des revues spécialisées, mais aussi d’assurer leur transfert, par exemple à travers des revues destinées aux enseignants, des ateliers ou encore le développement d’instruments.

Pour Urs Moser aussi, des efforts supplémentaires sont nécessaires afin d’amener la recherche dans les écoles et de les motiver à adopter des méthodes fondées sur les preuves. Il dit toujours communiquer les résultats de ses études aux établissements scolaires en expliquant la manière dont les conclusions peuvent être appliquées dans le développement de l’école ainsi que les modalités qui permettent aux enseignants de les exploiter à titre personnel. A l’instar de son collègue Wolfgang Beywl, il développe des instruments que les enseignants et les élèves utiliseront directement pour tirer des conclusions à partir des données, à l’image du logiciel Mindsteps qui rend visibles les progrès d’apprentissage. «Lorsqu’un outil est facilement accessible et utile, les enseignants se montrent très intéressés et désireux d’en apprendre davantage grâce à lui.»

Le politique se trompe de cible

Les autorités éducatives et politiques sont les acteurs les plus importants: elles décident en fin de compte de l’aménagement global de l’école. Et elles n’intègrent pas assez les connaissances scientifiques, avance Wolfgang Beywl, menant au contraire des discussions sur les mauvais sujets. Comme les questions structurelles, par exemple sur la sélection en différents niveaux scolaires, qui dominent les discussions politiques depuis plusieurs décennies. «Alors que nous savons par John Hattie que cette différenciation par niveaux n’influence pratiquement pas la réussite de l’apprentissage!» rappelle Wolfgang Beywl.

Pour lui, il serait bien plus judicieux de chercher des possibilités de réduire un peu la charge de cours des profs afin de dégager du temps pour assurer le développement de leur enseignement. Et notamment appliquer les connaissances issues de la recherche, collaborer avec des spécialistes scientifiques et contribuer à l’élaboration d’instruments de collecte des données. Bref, du temps pour améliorer leur enseignement, tout simplement.