Lorsque l’accusé est un robot

Qui doit assumer la responsabilité si un robot devait provoquer un accident? Les juristes anticipent l’autonomisation croissante de l’intelligence artificielle et débattent d’une question étonnante: comment punir une machine?

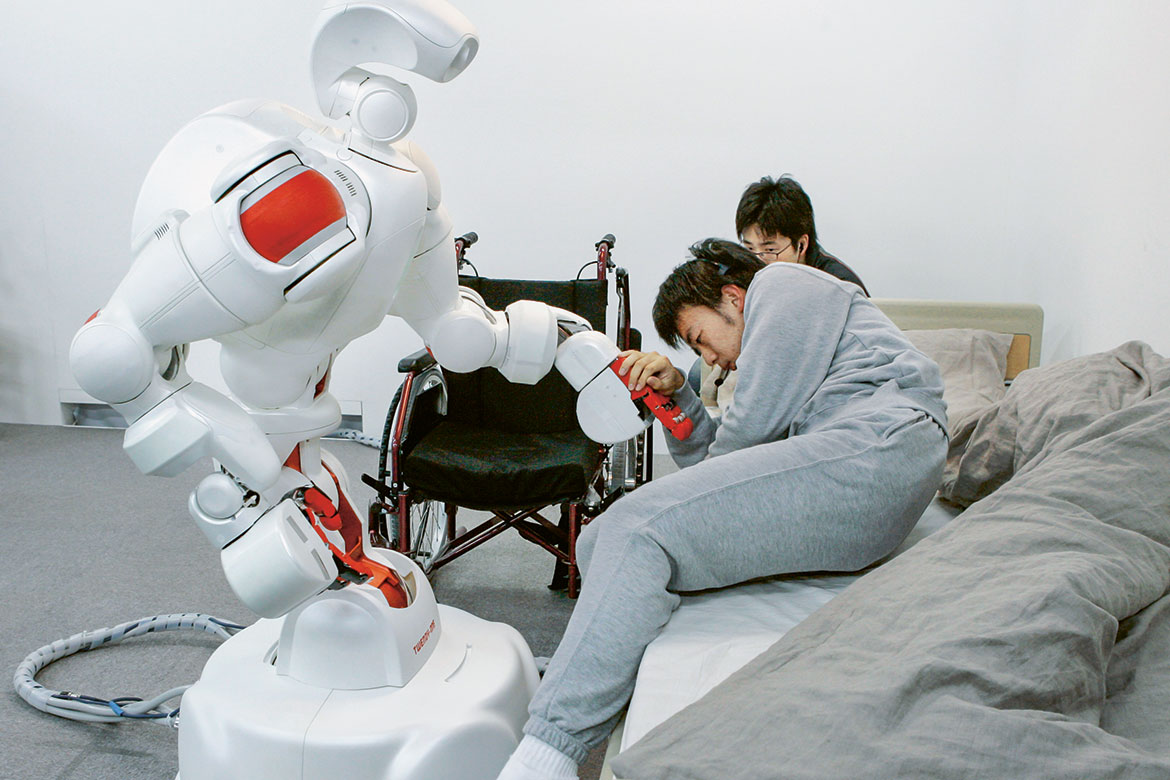

Développé à l’Université Wasada près de Tokyo, le robot Twendy-One, 111 kilos, aide un étudiant à monter dans une chaise roulante. Il s’agit ici d’une simple démonstration. Mais qui serait coupable en cas d’accident? Photo: Keystone/AP Photo/Koji Sasahara

Des machines travaillent à côté d’humains dans les usines, prennent soin de personnes âgées dans des homes et arrachent les mauvaises herbes pour les agriculteurs: l’intelligence artificielle interagit toujours davantage en contact direct avec des êtres humains et de manière plus autonome, avec un risque croissant d’accident. Plusieurs personnes ont perdu la vie dans des accidents impliquant des voitures autonomes, alors qu’un robot a écrasé un ouvrier dans une usine Volkswagen en Allemagne en 2015.

«Ce n’est qu’un début», dit Nora Markwalder, professeure assistante à la faculté de droit de l’Université de Saint-Gall et spécialiste du droit pénal et des nouvelles technologies. La situation soulève déjà des questions juridiques aussi importantes que délicates: qui faut-il tenir pour responsable si un robot soigneur laisse tomber une personne âgée, si un robot policier frappe violemment un passant ou si un chatbot appelle au meurtre?

«La question de la responsabilité n’est pour l’instant pas clarifiée», répond Nora Markwalder, qui a examiné la responsabilité juridique des automates et de l’intelligence artificielle avec la juriste Monika Simmler. «La plupart des gens considèrent comme absurde l’idée de punir un robot.» Une telle mesure serait d’ailleurs encore impossible actuellement, car les machines intelligentes ont un statut d’objet et, en tant que tel, ne possèdent pas la capacité pénale en droit suisse. L’intelligence artificielle n’a en outre pas atteint un niveau de développement suffisant pour prendre des décisions librement et ainsi être considérée comme responsable de ses actes. «Mais si elle devait à l’avenir en être capable, il serait parfaitement sensé de la traduire en justice», estime Nora Markwalder. Pas tant dans l’espoir que la machine ne s’amende, mais plutôt pour confirmer les normes en vigueur, en transmettant le message que personne ne saurait tuer impunément, pas même un robot, poursuit la professeure.

Condamné à la ferraille

ferrailleLes deux expertes se sont penchées sur le type de peines envisageables. Elles devraient, d’une manière ou d’une autre, «faire mal» à la machine. «Cela ne peut bien entendu pas être la même chose que pour des humains», dit Nora Markwalder. Plutôt que d’emprisonner un robot, on pourrait par exemple réduire sa puissance de calcul. Ou l’envoyer à la ferraille, l’équivalent de la peine de mort. «Tout cela relève encore de la science-fiction», reconnaît la chercheuse. Mais elle est d’avis qu’il est important d’aborder suffisamment tôt des problèmes qui finiront un jour par se poser.

Trop compliqué pour la justice

«Il y a des questions plus urgentes, comme celles liées aux véhicules autonomes et aux robots industriels, notamment au sujet de la protection des données et de la responsabilité», remarque Sabine Gless, qui étudie la problématique des données générées par les voitures sans chauffeur dans le cadre du Programme national de recherche Big Data. Pour la professeure de droit à l’Université de Bâle, il est clair qu’on demande aujourd’hui des comptes aux humains et non aux machines en cas d’accident impliquant un système autonome: le programmeur qui aurait par négligence développé un algorithme déficient, l’employé dans la production qui n’a pas fait attention à un défaut de matériel ou l’utilisateur qui a utilisé la machine de manière inadéquate. Mais la tâche du tribunal – examiner au cas par cas si quelqu’un a commis une erreur – devient plus difficile à mesure que les systèmes se complexifient. «Aujourd’hui déjà, un examen approfondi ne permet plus toujours de déterminer la faute», souligne Sabine Gless.Il peut donc arriver qu’on ne parvienne pas à identifier le coupable et que personne ne soit condamné.

Un constat que partage la juriste Monika Simmler, qui mène actuellement une étude à l’Université de Saint-Gall pour connaître l’avis de la société sur ces questions. Des participants sans connaissances juridiques particulières doivent définir dans plusieurs situations le responsable: la personne, le système autonome ou les deux. Un exemple: un train qui déraillerait parce que le mécanicien a enclenché un système de pilotage automatique comprenant cinq degrés d’autonomie croissante. Monika Simmler s’attend à ce que les participants se montrent plus cléments envers l’humain si le système est fortement intervenu.

Susanne Beck, professeure de droit pénal à l’Université de Hanovre, voit les choses différemment. Pour elle, il n’est pas forcément problématique que personne ne soit condamné après un accident impliquant un véhicule autonome: cela est déjà le cas pour d’autres technologies considérées comme suffisamment utiles par la société pour qu’elle en accepte les risques, telles les centrales nucléaires. Avant de se demander de quelle manière punir les robots, la société devrait d’abord engager un débat pour savoir si et où elle veut recourir à l’intelligence artificielle. «Et si l’on décide de le faire, il faut accepter que quelque chose puisse mal tourner.»

Mais il ne convient cependant pas d’oublier les personnes lésées, poursuit la chercheuse: la question de la responsabilité civile (et non pénale) doit être clairement réglée afin que celles-ci touchent des indemnités ou des compensations en cas d’incident avec un robot. Susanne Beck réfléchit à la création d’un statut juridique particulier pour les robots: la «personne électronique», comparable à la personne morale (entreprises, associations, etc.), et sur laquelle le Parlement européen se penche déjà. Une possibilité consisterait à exiger des producteurs, des propriétaires et des exploitants d’un robot de déposer ensemble une caution financière qui serait utilisée lors d’un dommage. La création de cette nouvelle personnalité juridique suscite toutefois une opposition chez les spécialistes en robotique. Dans une lettre ouverte à l’UE, ils la jugent prématurée, dénoncent une surévaluation des possibilités actuelles de l’intelligence artificielle et craignent qu’un tel cadre légal ne freine l’innovation.

Claudia Hoffmann est journaliste scientifique et travaille pour l’institut de recherche SLF à Davos.