SCIENCE REPRODUCTIBLE

Moins de statistiques, plus d’intuition

Les chercheurs en médecine et en sciences sociales s’efforcent de réduire les biais qui affectent les résultats publiés. Ils pourraient s’inspirer de la physique selon des chercheurs en méthodologie.

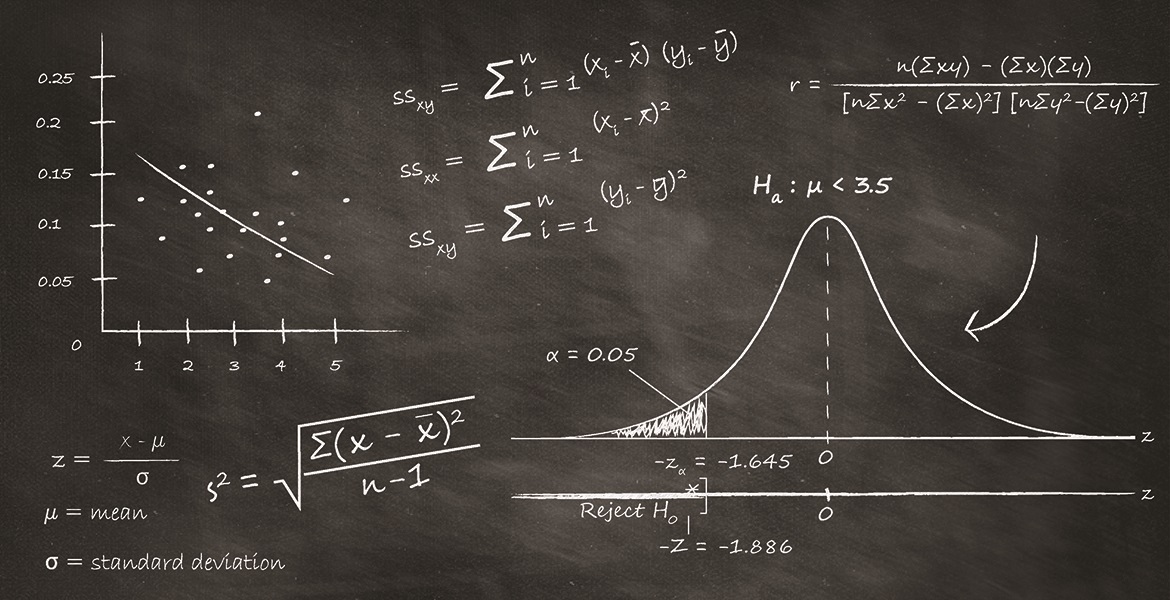

Selon certains sociologues des sciences, avoir une idée précise de ce à quoi il faut s'attendre est plus important que d'analyser des chiffres. | Photo: màd

Ne publier que les résultats d’expériences qui apportent des nouveautés attrayantes semble contredire l’idée de base de la science comme quête désintéressée de la vérité. Toutefois, de la médecine à l’économie, en passant par la sociologie et la psychologie, c’est souvent ce que font les scientifiques. Ils ne consignent leurs résultats et ne les soumettent à des revues que lorsqu’ils identifient un effet «positif». Par conséquent, tout ou partie des résultats nuls finit au fond d’un tiroir.

Ce biais de publication crée une fausse image de la connaissance scientifique dans son ensemble, car la prévalence artificielle des résultats positifs fausse les méta- analyses sur lesquelles s’appuient de nombreux domaines. Et ce biais entraîne un gaspillage d’efforts lorsque des études «négatives» ne sont pas publiées.

De surcroît, de nombreuses données publiées sont sujettes à caution en raison du recours à toute une série de procédés statistiques sophistiqués pour extraire un signal supposé d’un océan de bruit alors que, selon toute vraisemblance, il n’en existe aucun. Cette production de faux résultats positifs trompe les scientifiques et le grand public. Ce qui constitue un problème en particulier en médecine où de nombreux prétendus traitements s’avèrent être de faux espoirs.

Certains scientifiques ont tenté de résoudre ces problèmes en exigeant plus de transparence dans la publication des données et des méthodes, en particulier par le préenregistrement. Ce processus exige que les éditeurs consignent le protocole de recherche et les techniques statistiques avant même la collecte des données, puis publient le résultat, qu’ils apportent ou non des nouveautés intéressantes.

Toutefois, certains experts estiment que le préenregistrement peut entraver la liberté nécessaire à de nouvelles découvertes, tandis que d’autres proposent des changements plus fondamentaux. Sociologue des sciences à l’Université de Cardiff, Harry Collins soutient que la médecine et les sciences sociales pourraient s’inspirer de la manière dont les physiciens combinent statistiques et intuition physique. «La solution à ce type de biais ne doit pas être cherchée chez les éditeurs, mais dans la façon dont la science est pratiquée par les scientifiques», estime-t-il.

Le problème des biais dans la recherche scientifique est discuté depuis des années. En 2005, John Ioannidis, spécialiste en sciences médicales de l’Université Stanford en Californie, affirmait que la plupart des découvertes publiées en médecine étaient probablement fausses. Il avait analysé l’utilisation par les chercheurs de la valeur P – soit, comme il le disait, la probabilité qu’un signal apparaisse alors qu’en réalité il n’en existe aucun. Selon lui, en écumant de larges ensembles de données et en fixant la valeur P à 5%, les chercheurs généraient presque certainement de nombreux effets factices.

Les essais médicaux figurent parmi les domaines les plus critiqués pour leurs biais. Mais certains signes montrent que leur partialité a diminué: en 2015, aux Etats-Unis, une étude de l’Agence pour la recherche et la qualité des soins de santé a constaté que les analyses cliniques de traitements cardiovasculaires avaient livré plus de résultats positifs avant l’an 2000 qu’après. Toutefois, il y a aussi eu de fameux échecs cuisants, comme les informations retenues par l’entreprise pharmaceutique Roche sur son médicament antiviral Tamiflu.

Les psychologues se sont également efforcés de rendre leurs recherches plus fiables après avoir découvert que de nombreux résultats retentissants des années 1950 étaient tout simplement non reproductibles. Ce fut d’ailleurs le premier domaine à introduire le préenregistrement. Depuis, la pratique s’est étendue à d’autres domaines, dont la médecine.

Pour John Ioannidis, le préenregistrement a contribué à réduire le problème des «fonds de tiroir» dans les sciences en général. Mais selon lui, le problème du choix sélectif de données favorables s’est aggravé, le préenregistrement ne suffisant pas à supprimer tous les «degrés de liberté» ouverts aux prétendus statisticiens débrouillards. «Nous avons maintenant plus de données, plus d’instruments complexes, plus d’enseignants – mais pas assez de scientifiques formés, dit-il. Dans ces circonstances, il est bien plus facile de générer des signaux qui ne tiendront pas la route.»

Traiter les animaux comme des patients

Le biais de publication pose un problème particulier dans le domaine des expérimentations animales. La prochaine votation sur l’initiative qui exige qu’elles soient largement interdites en Suisse a provoqué la consternation parmi les académiciens. L’organisation faîtière des hautes écoles du pays, swissuniversities, a fait valoir que ces expériences sont nécessaires pour développer des médicaments, soulignant qu’un règlement strict imposait déjà aux chercheurs de respecter la dignité et le bien-être des animaux et qu’ils devaient obtenir l’autorisation des autorités vétérinaires cantonales.

Évaluation visuelle de la situation de l'étude: dans la trame en entonnoir popularisée par l'épidémiologiste bernois Matthias Egger, les petites études se trouvent en bas. Elles sont largement dispersées autour de la valeur moyenne (ligne pointillée). Les grandes études, précises, sont au sommet. A droite: Les petites études indiquent déjà la cause de la maladie. La situation est équilibrée. A gauche: Parmi les petites études, seules celles qui pouvaient montrer un effet de la thérapie ont probablement été publiées. Plus les études étaient importantes, plus l'effet s'est avéré être un leurre. | Graphiques: Bodara d'après M. L. Ritchie et al. 2012 (à gauche) et S. S. Liyanage et al. 2013 (à droite).

Daniele Fanelli, spécialiste de l’intégrité de la recherche à la London School of Economics, estime en revanche qu’un peu de biais de publication peut être positif pour surmonter un problème d’encombrement, à savoir la difficulté d’identifier les découvertes intéressantes noyées dans les résultats nuls. Mais il reconnaît que la recherche d’un équilibre entre cette difficulté et les tiroirs encombrés de dossiers «diffère selon les domaines». En réalité, il soutient la vieille idée d’une «hiérarchie des sciences» au sein de laquelle, selon lui, les disciplines peuvent se distinguer par la mesure dans laquelle les données «parlent d’ellesmêmes » et les théories peuvent être rigoureusement testées. Il a développé cet argument en 2010 dans une analyse portant sur près de 2500 articles de toutes les disciplines scientifiques qui ont déclaré avoir testé une hypothèse. Son constat: les chercheurs en sciences sociales, au bas de la hiérarchie, étaient bien plus susceptibles de rapporter des résultats positifs que ceux des sciences physiques.

Harry Collins est aussi convaincu qu’il est crucial de distinguer les domaines. Il souligne que les physiciens ont développé des normes très rigoureuses pour l’interprétation des statistiques, fixant le seuil de découverte à 5 sigma, ce qui signifie qu’il n’y a qu’une chance sur 3,5 millions qu’un signal soit dû au hasard. Il note que, lors de la découverte des ondes gravitationnelles en 2015, ce ne sont pas les statistiques qui ont persuadé les chercheurs d’avoir touché le jackpot, mais le fait que les signaux ondulatoires détectés correspondaient à ce qu’ils attendaient de la fusion de deux trous noirs.

Si les chercheurs en sciences sociales et en médecine veulent surmonter les biais et publier des résultats reproductibles, ils doivent regarder au-delà des valeurs P et acquérir un sens de ce qui se passe dans leurs expériences, estime Harry Collins: «Souvent, les gens ne comprennent pas à quoi servent les statistiques. Celles-ci constituent fréquemment un prétexte pour ne pas faire véritablement de la science.» John Ioannidis convient que les chercheurs doivent cesser de se focaliser sur la valeur P, mais propose une solution plus directe: les administrateurs devraient imposer certaines règles, telles que le préenregistrement dans certains cas, tandis que les chercheurs devraient être instruits de la nécessité de la rigueur. «Les scientifiques bien formés savent que cela fait partie intégrante d’une bonne science, dit-il. Encore faut-il qu’ils le soient.»